最終更新日:

【NLP講座体験記後半】Transformerモデルを理解しNLPの実装スキルを獲得した2日間

1.はじめに

こんにちは、スキルアップAIの五十嵐です。

前回の記事では自然言語処理について実践的に学べるNLP講座のDay1およびDay2についての受講体験記を書かせていただきました。

今回は受講体験記の後半として、Day3・4の内容について書かせていただきます。

後半ではBERTをはじめとしたTransformerモデルを実際に触ることができます。

その手軽さと精度の高さに驚いたことが少しでも伝わればと思います!

2.目的に対して最短距離でPytorchを理解、実践的なモデル構築ができる

皆さんはPytorchをご存知でしょうか?

Pytorchは深層学習モデルを構築するのに利用されるフレームワークの1つです。

Pytorchは主に研究者から大きな支持とシェアを誇っており、今最もメジャーな深層学習フレームワークだと言えるでしょう。

この講座ではPytorchの簡単な入門講座としての側面も備えています。

その上、このPytorchへの入門は今まで見てきたどんなPytorch入門講座よりも理解がしやすい内容でした。

というのも、他のPytorch入門講座とは違い、Pytorch学習する内容をあくまでも今後NLP講座で扱う内容に絞っているため、明確な目的がある上に覚える内容は最小限、そしてあくまでもツールとして利用していく上でPytorchに慣れることができるような内容になっていたからです。

この講座でのPytorchは『深層学習を実行するためのフレームワーク』というよりも『自然言語処理を行う上で必要なライブラリ』というような立ち位置です。

あくまでもツールとして扱っているので、特に難しいことを考えず利用しているうちに、自然とPytorchの扱いに慣れることができました。

さらに、通し課題に取り組むことで、非常に実践的にPytorchを利用できるようになれたと実感しています。

3.知識と実践の両面からアプローチ。講師の知見を追体験しながら実際に計算結果を考察

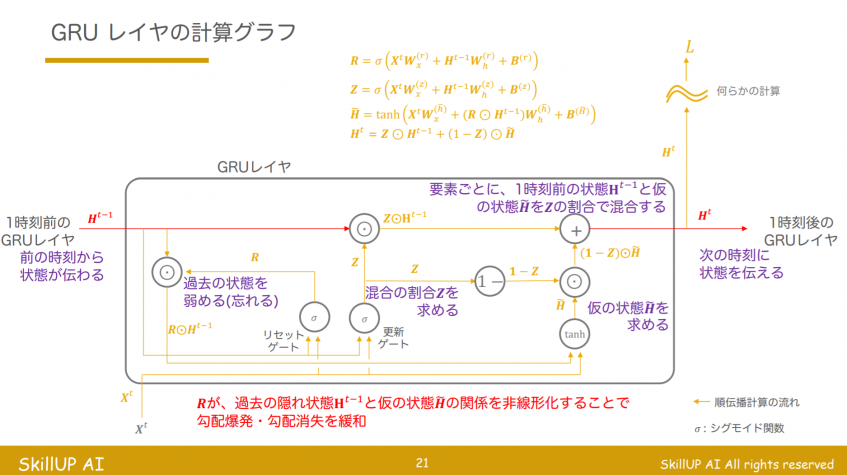

この講座では、DAY3で、RNN、LSTMなどの再帰型ニューラルネットワークモデルについて学習します。

これらはディープラーニング講座でも学ぶ内容ですが、NLP講座では実際にモデルを動かした後、講座で講師からフィードバックを得つつ、数式と実際の動作の両面からモデルの特性を学ぶことができます。

理論ももちろん詳しく解説されますが、受講者一人ひとりの課題に対して、講師がフィードバックしつつ実践でどのような挙動を示すのか、どのようなことを意識してモデルを組むのかなど、現役エンジニアである講師の実体験を元にした内容を理論と一緒に聞けることが、非常に実践的で有意義でした。

理論的な背景の解説はもちろんのこと、

コードを実際に動かしつつ、入出力の確認から動作の解釈や学習のテクニックなど、講師の体験が多く盛り込まれた内容を聞くことができます。

4.アテンションについての詳細な解説でTransformerを理解する基礎力が身に付く

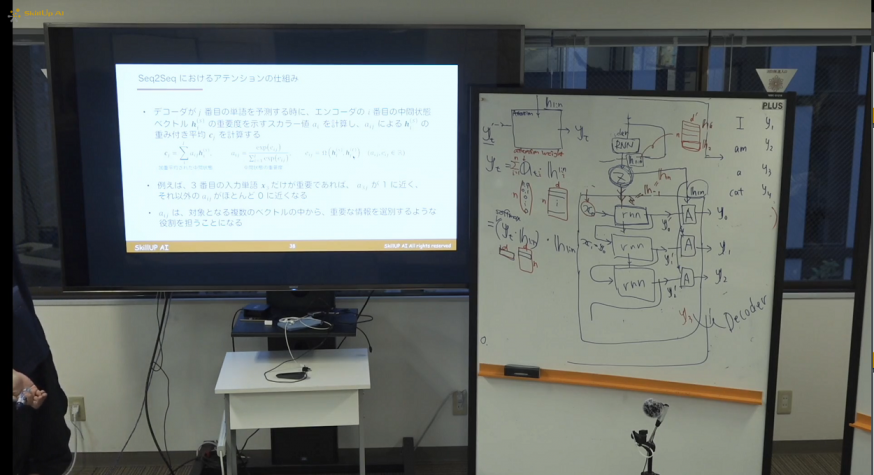

RNN、LSTMなど、深層学習における時系列モデルをDAY3で多く学びますが、DAY3で特に力が入れられているのは「アテンション」の解説でした。

Transformerは全結合層・畳み込み層・アテンションを中心に構成されるモデルです。

特に構造の理解にはアテンションを理解することが非常に重要になります。

ただ、このアテンション、数式だと非常にイメージし辛い部分があります。 スライドを見てもなかなか理解できなかったため、講師のホワイトボードを利用した数式を交えての解説が、非常にわかりやすかったです。

特に、このありがたさはDAY4でTransformerを学んだ際に実感できました。

ディープラーニング講座で少し触れられた際に全く理解できないままでいたTransformerの理論が、非常に理解しやすくなりました。

アテンションという技術には様々な派生が存在し、DAY4で実際に利用されている様々なアテンションを学ぶ上で、DAY3でその基礎を理解することが重要であるとわかりました。

5.講座を通し取り組んできた課題の意義が、Transformerモデルを利用したデータ分析を体験することで、跳ね上がる

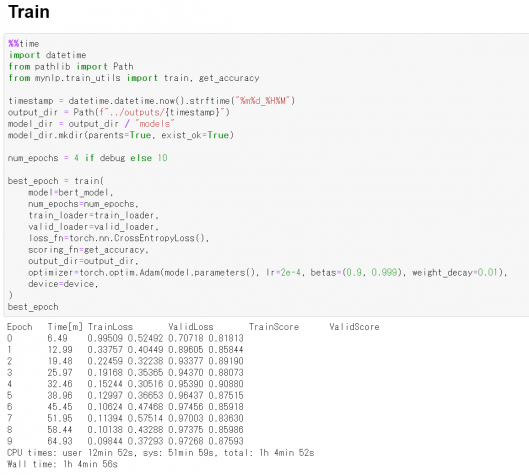

この講座ではBERTやGPT-2など、有名なTransformerを利用したデータ分析を実際に体験することができます。 そして、その体験をすばらしいものにするのは、自分が今まで取り組んできた課題です。

DAY3まで、私は様々な技術を駆使して通し課題に取り組んできました。

しかし、Transformerは簡単に利用できる上に、単純に利用しただけで今まで頑張ってきたモデルに迫る精度を簡単に出してしまったのです。 もちろん動かしたままで満足することなく、今まで学習した内容を取り入れたり、工夫を凝らすことによって、更に高精度なモデルを作成することができました。

(画像:BERTの訓練)

これだけ簡単に利用できるとなると、自分で何か自然言語処理のタスクに取り組む際に真っ先に試すこともできます。

6.まとめ

講座の後半では深層学習を用いたモデルを多く利用しましたが、それぞれが理論と実践を同時並行で学べるため、まるで駆け抜けるように最新の情報にアクセスできる基礎力を、効率的に身につけることができました。

特に、Transformerがどうやって動作しているのか、どのように動作させれば良いのかを学べたことで、今後、仕事や研究に取り組む上で、新たな選択肢を手に入れることができました。

今後、この講座で学んだことを、ふんだんに生かしていきたいです。

配信を希望される方はこちら

また、SNSでも様々なコンテンツをお届けしています。興味を持った方は是非チェックしてください♪

公開日: