最終更新日:

差分プライバシーの概要と機械学習への応用

こんにちは。スキルアップAIの山本です。現在は、ゲノムデータに関する統計量についてのプライバシー保護技術の研究に取り組んでいます。

本ブログでは、効率的なプライバシー保護手法として近年注目されている「差分プライバシー」の概念と、その機械学習への応用についてお話しします。この記事が、データに含まれる個人のプライバシーについて考えたり、差分プライバシーの理論の面白さに触れたりするきっかけになれば幸いです。

1.差分プライバシーとは

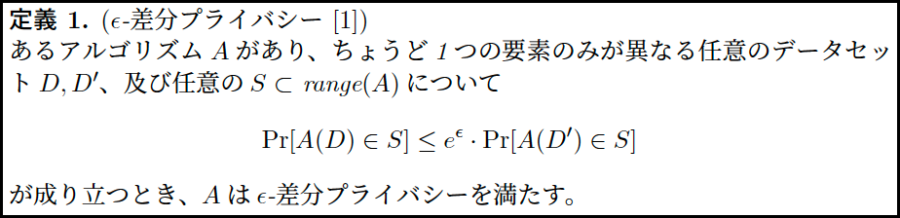

「差分プライバシー」は、データベース内の個人情報を攻撃者から守りつつ、統計的な解析を可能にする枠組みとして、Dwork[1]によって開発された概念です。差分プライバシーでは、「ある個人のデータを含むデータセットを用いた処理結果が、ある個人のデータが、その個人以外の(かもしれない)誰かのデータに変わったデータセットを用いた処理結果と区別できないなら、プライバシーは確保されている」と考えます。より厳密には、差分プライバシーは、パラメータεを用いて、定義1のように定義されます。以下の定義1の式を満たすとき、Aはε-差分プライバシーを満たす、といいます。定義1の内容は、直感的には分かりづらいと思うので、図1を使って説明していきます。

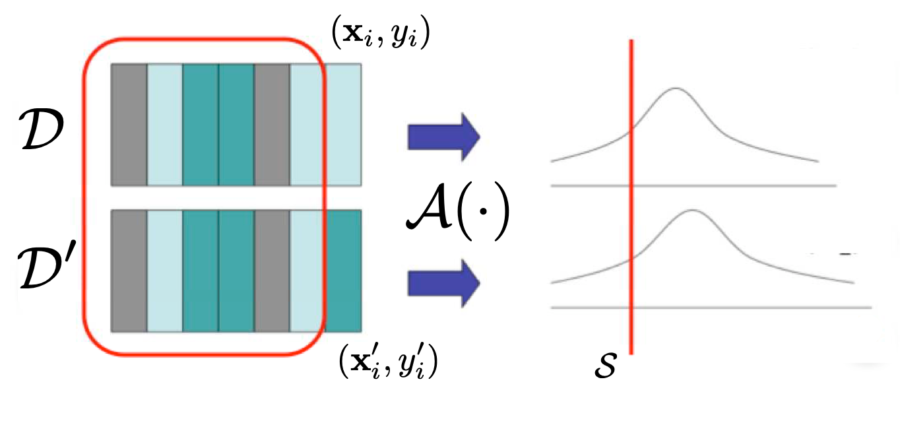

図1. 差分プライバシーの概念図

(参考文献[2]より引用)

図1におけるDʼ は、D の1つのレコード (xi, yi) のみが (xʼi, yʼi) に変わったデータセットです。図1では、これら2つのデータセットにアルゴリズムAを適用することを考えています。D, Dʼ に対する出力結果は、互いに異なる1つのレコード分しか違いが生じないので、ほとんど区別できないものになると予想されます。

その区別できなさをεとして表すことにして、出力が任意の S に含まれる確率の比を評価することで、個人(図1では (xi, yi) のこと) のプライバシーがある程度守られていることにする、というのがε-差分プライバシーの概念です。

以上で差分プライバシーの基本的な定義について説明しましたが、結局、他のプライバシー保護技術と比べて何が嬉しいのでしょうか。おそらく皆さんが、「プライバシー保護」と聞いて最も頭に浮かぶ技術は、「匿名化」や「秘密計算」だと思います。しかし、実は、「匿名化」は統計量などのデータには使い物にならないことが多いという問題があり、「秘密計算」は計算量が大きすぎて大規模なデータセットには適用できない、という問題があります。「差分プライバシー」にはそのような問題はなく、元のデータに少しの摂動を加えるだけで簡単にプライバシーを保護できます。この点において、「差分プライバシー」は、機械学習においても活用しやすい手法であるといえます。

それでは、ε-差分プライバシーを達成するメカニズムについていくつか紹介します。

2.主要なメカニズム

有名なメカニズムとして、「ラプラスメカニズム[3]」・「ガウシアンメカニズム[4]」・「指数メカニズム[5]」などがあります。前2つは各出力値に摂動を加える方法であり、後1つは解析者が得たい出力値のみを高い確率で取り出せるように考えられた方法です。以下では、「ラプラスメカニズム」および「指数メカニズム」について説明します。

2-1.ラプラスメカニズム

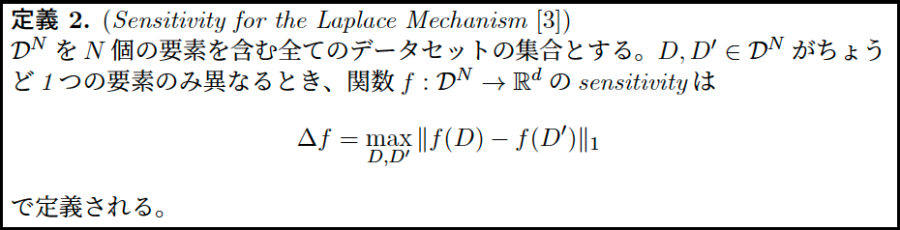

ラプラスメカニズムでは、各出力値を得るための関数のsensitivity を考慮し、それに応じたノイズを加えます。ラプラスメカニズムにおけるsensitivity の定義は以下のようになります。 この定義に従ってあるアルゴリズムのsensitivity を求め、そのアルゴリズムの出力値に平均0, スケールΔf/εのラプラス分布 に基づくノイズを加えれば、ε-差分プライバシーを達成できます。なお、定義2においては、関数fがアルゴリズムにあたります。

ガウシアンメカニズムも同様で、アルゴリズムの出力値にsensitivity に応じたノイズを加えるだけで良いという、とても単純なメカニズムになっています。

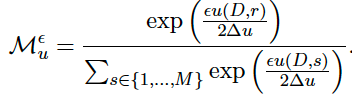

2-2.指数メカニズム

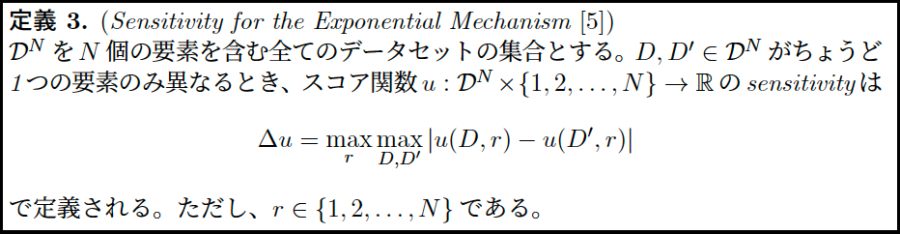

指数メカニズムは、ラプラスメカニズムやガウシアンメカニズムとは異なり、取り出したいデータの特徴がわかっている場合に適したメカニズムです。例えば、統計量の最も大きいデータが欲しい場合やあるグループに含まれるもののうち境界に近いデータが欲しいという場合が挙げられます。このメカニズムでは、データセットに応じてスコア関数を定義し、得られたスコアとそのsensitivity によって計算される指数関数を用いた確率分布に従ってあるデータを出力します。ここで、スコア関数は、「各データが出力される望ましさ」を表しており、この値が大きいデータほど出力される確率が上がります。そして、指数メカニズムにおけるsensitivity は、1つの要素のみが異なる2つのデータセット間で変化するスコアの最大値のことであり、1つの要素が変わった場合に、出力される望ましさが最大どれほど変わるのか、を表しています。以下に指数メカニズムにおけるsensitivity の定義、およびε-差分プライバシーを達成するための条件を示します。少し難しい数式ですが、「欲しいデータをプライバシー保護しながら高い確率で取り出したい」、という気持ちで見ると分かりやすいかもしれません。

以上のメカニズムを使ったり、組み合わせたりすることで、プライバシー保護を達成できる可能性があります。このプライバシー保護の技術は、機械学習にも応用できます。次節では、機械学習への応用について紹介していきます。

3.差分プライバシーの機械学習への応用

3-1.経験損失最小化

Chaudhuriら[2]は、経験損失最小化に着目し、損失関数と正則化に関するいくつかの条件下で、ε-差分プライバシーを保証するアルゴリズムを提案しました。

1つ目は”Output Perturbation”というアルゴリズムであり、これは分類器の sensitivity に応じて出力にノイズを加える方法です。

そして、2つ目は“Objective Perturbation”というアルゴリズムであり、これは目的関数にノイズを加える方法です。

この2つのアルゴリズムは、ノイズを加えるフェーズが異なります。ただ単に3章で述べたメカニズムを適用させるだけでは良い結果は得られない、という点は非常に面白いです。

3-2.確率的勾配降下法

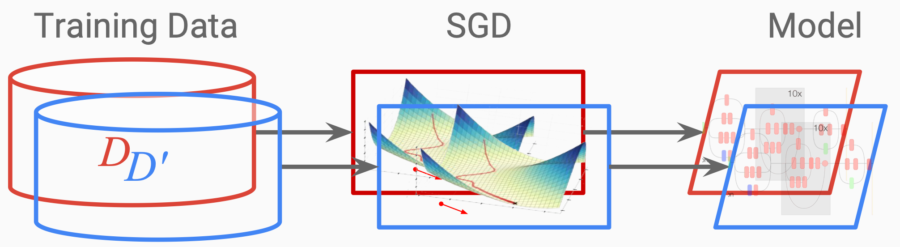

Abadiら[6]は、確率的勾配降下法 (SGD) に関するプライバシー保護手法を提案しました。概念図を以下に示します。

図2. 差分プライバシーを用いた確率的勾配降下法の概念図

(https://course.ece.cmu.edu/~ece734/fall2016/lectures/Deep_Learning_with_differential_privacy.pdfより引用)

Abadiらは、パラメータ更新の際に、勾配にノイズを加えることを提案しており、これによってε-差分プライバシーを満たすことを目指しています。ただ、適切なεの選択方法は確立されておらず、精度とプライバシーレベルのトレードオフの問題も今後議論する必要があります。

3-3.その他

MCMCに関する研究[7]や、教師モデルを組み合わせることによる保護手法[8]など、機械学習の様々なアルゴリズムとの融合が試みられており、差分プライバシーと機械学習に関する研究のさらなる発展が見込まれます。

4.今後の課題

最も重要な課題として、プライバシーレベルと実用性のトレードオフの問題があります。どの程度強く、すなわちどれほど小さいεにすれば、⼀般的に「プライバシー保護されている」と言えるのか、という議論は、我々のような理論に近い人間だけでは難しい部分もあり、社会や法の観点からのアプローチも重要であるといえます。

また、本ブログでは触れませんでしたが、データセット間に依存性がある場合は、単純な差分プライバシーの概念では、正しく個人の保護がなされないことがあります。このように、まだ差分プライバシーが使える領域は限られているということを意識しつつ、機械学習の分野でも、さらに研究が進み、発展していくことを望んでいます。

5.おわりに

スキルアップAIでは、関連講座として「現場で使える機械学習・データ分析基礎講座」を開講中です。 機械学習の概論から始まり、徐々にそれぞれのアルゴリズムの核心を学べるように設計しています。是非ご検討ください。

また、毎週水曜日に実践的AI勉強会「スキルアップAIキャンプ」を開催しています。勉強会では、様々な実践的テーマを取り上げ、データ分析・AI開発の実務力アップにつながるヒントをご提供します。講師が参加者の皆さんからの質問や悩みに答えるコーナーもあります。

興味がある方はぜひ参加してみてください!

6.参考文献

[2] K. Chaudhuri, C. Monteleoni, and A. D. Sarwate. Differentially private empirical risk minimization. Journal of Machine Learning Research, 12(29):1069̶1109, 2011.

[3] C. Dwork, F. McSherry, K. Nissim, and A. Smith. Calibrating noise to sensitivity in private data analysis. S. Halevi and T. Robin, (eds) Theory of Cryptography, 3876:265̶284, 2006.

[4] C. Dwork, K. Kenthapadi, F. McSherry, I. Mironov, and M. Naor. Our Data, Ourselves: Privacy via distributed noise generation. In EUROCRYPT 2006, pages 486̶503, 2006.

[5] F. McSherry and K. Talwar. Mechanism design via differential privacy. In 48th Annual IEEE Symposium on Foundations of Computer Science, pages 94̶103, 2007.

[6] M. Abadi, A. Chu, I. Goodfellow, B. McMahan, I. Mironov, K. Talwar, and L. Zhang. Deep learning with differential privacy. In 23rd ACM Conference on Computer and Communications Security, pages 308̶318, 2016.

[7] B. Li, C. Chen, H. Liu, and L. Carin. In Twenty-Second International Conference on Artificial Intelligence and Statistics, pages 557̶566, 2019.

[8] N. Papernot, M. Abadi, Ù. Erlingsson, I. Goodfellow, and K. Talwar. Semi-supervised knowledge transfer for deep learning from private training data. In 5th International Conference on Learning Representations, 2017.

【監修】スキルアップAI 取締役CTO 小縣信也

AI指導実績は国内トップクラス。「太陽光発電発電量予測および異常検知」など、多数のAI開発案件を手掛けている。日本ディープラーニング協会主催2018E資格試験 優秀賞受賞、2019#1E資格試験優秀賞受賞。著書「徹底攻略ディープラーニングE資格エンジニア問題集」(インプレス)。

配信を希望される方はこちら

また、SNSでも様々なコンテンツをお届けしています。興味を持った方は是非チェックしてください♪

公開日: