最終更新日:

FPGAと機械学習

こんにちは。スキルアップAIの渥美です。私は現在、FPGAを用いた深層学習の推論高速化について研究をおこなっています。

AIは凄まじい速さで日々成長しており、その中でも知能を持つエッジデバイスである「エッジAI」が注目を集めています。 今回のブログでは、そのエッジAIと深いかかわりを持つFPGAについて、ランダムフォレストの事例[1]を交え紹介します。

1.FPGA

FPGAは、Field-Programmable Gate Arrayの略称であり、書き換え可能なハードウェアデバイス(大規模集積回路)のことを指します。 書き換えが可能なハードウェアデバイスであることから、FPGAは「やわらかいハードウェア」と表現されることもあります。

では演算を実行する場合、FPGAとCPUとでは何が違うのでしょうか?

CPUで演算を実行する場合、高級言語により記述された命令は、コンパイラにより、アセンブリ、機械語へと変換され、実行されます。

このとき、一般的には、どれほどのハードウェア資源を割り当てるのか詳細に決定することができません。

これに対し、FPGAに対してハードウェア設計言語(HDL)を用いてプログラムを書いた場合、その演算に最適なハードウェア資源を割り当てる設計が可能になります。

ゆえに、FPGAは、資源の限られたエッジAIに適したハードウェアであると言えます。

2.ランダムフォレストの計算におけるGPUとFPGAの違い

前節にて、FPGAの特徴として、最適なハードウェア設計が可能であることを挙げました。

ここでは、分類問題おけるランダムフォレストの推論を例に、最適なハードウェア設計について考えます。

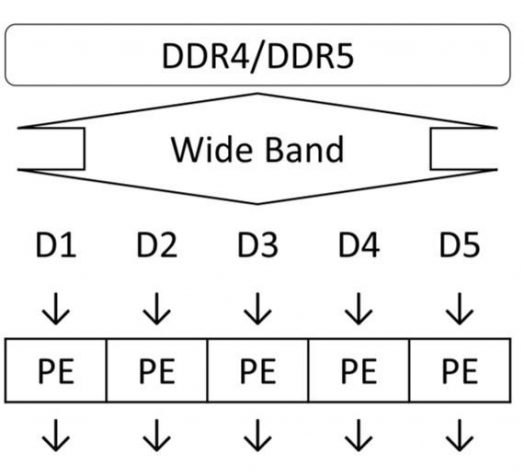

分類問題におけるランダムフォレストの推論では、入力値を複数の決定木に渡し、それら決定木の判定結果から多数決をとり、出力を決定します。 ランダムフォレストの推論は通常、CPUで実行されますが、GPUで実行することも可能です。 GPUにて実行する場合の概念図を図1に示します。CPUの場合も、基本概念は図1と同じです。 図1において、DDR4/DDR5はメモリ、PE(processing element)は処理の単位を示します。ランダムフォレストにおける決定木の計算(D1〜D5)は各PEで実行されます。 GPUは複数のコアを持っているため、PEを並列に処理できます。

このとき、各決定木のモデル情報をメモリ(DDR4/DDR5)からPEに渡すため、広い帯域(wide band)が必要です。

また、各決定木の大きさはそれぞれ異なるため、各決定木の計算時間に差が出ます。 これにより、待ち時間が発生します。

図1. GPU上でのランダムフォレストの構成

※D1~D5が推論を行う各決定木、PEはProcessing Element、DDR4/DDR5はメモリを示す

(参考文献[1]より引用)

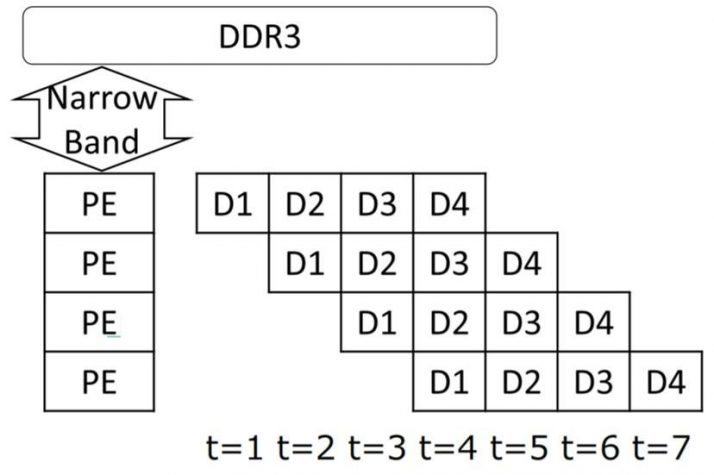

FPGAは、書き換え可能なハードウェアデバイスであるため、ランダムフォレストに最適な処理過程を自分で実装することができます。ランダムフォレストにおける推論処理をFPGAに行う場合概念図を図2に示します。図2は、複数の入力データを順次処理していく過程を示しています。各決定木のモデル情報はメモリ(DDR3)からPEに伝えられますが、PE間でその情報を伝達するため、メモリとPE間は狭い帯域(narrow band)で十分です。FPGAは、GPUに比べオンチップメモリが大きいため、PE間の伝達を実現できます。各PEにおける処理は、D1からD4に向かって順に実行されます。決定木の処理は直列であるため、各決定木の大きさが異なっていたとしても、多数決をとる際の待ち時間は発生しません。このため、ハードウェア資源を効率よく使えることになります。

また、FPGAでは、ビット長を固定することができます。これにより、浮動小数点数で表現するCPUやGPUに比べ、ハードウェア資源を節約したり、演算を高速化することができます。

図2. FPGA上でのランダムフォレストの構成

※D1~D4が各決定木、PEはProcessing Element、tは時刻、DDR3はメモリを示す

(参考文献[1]より引用)

3.実験結果

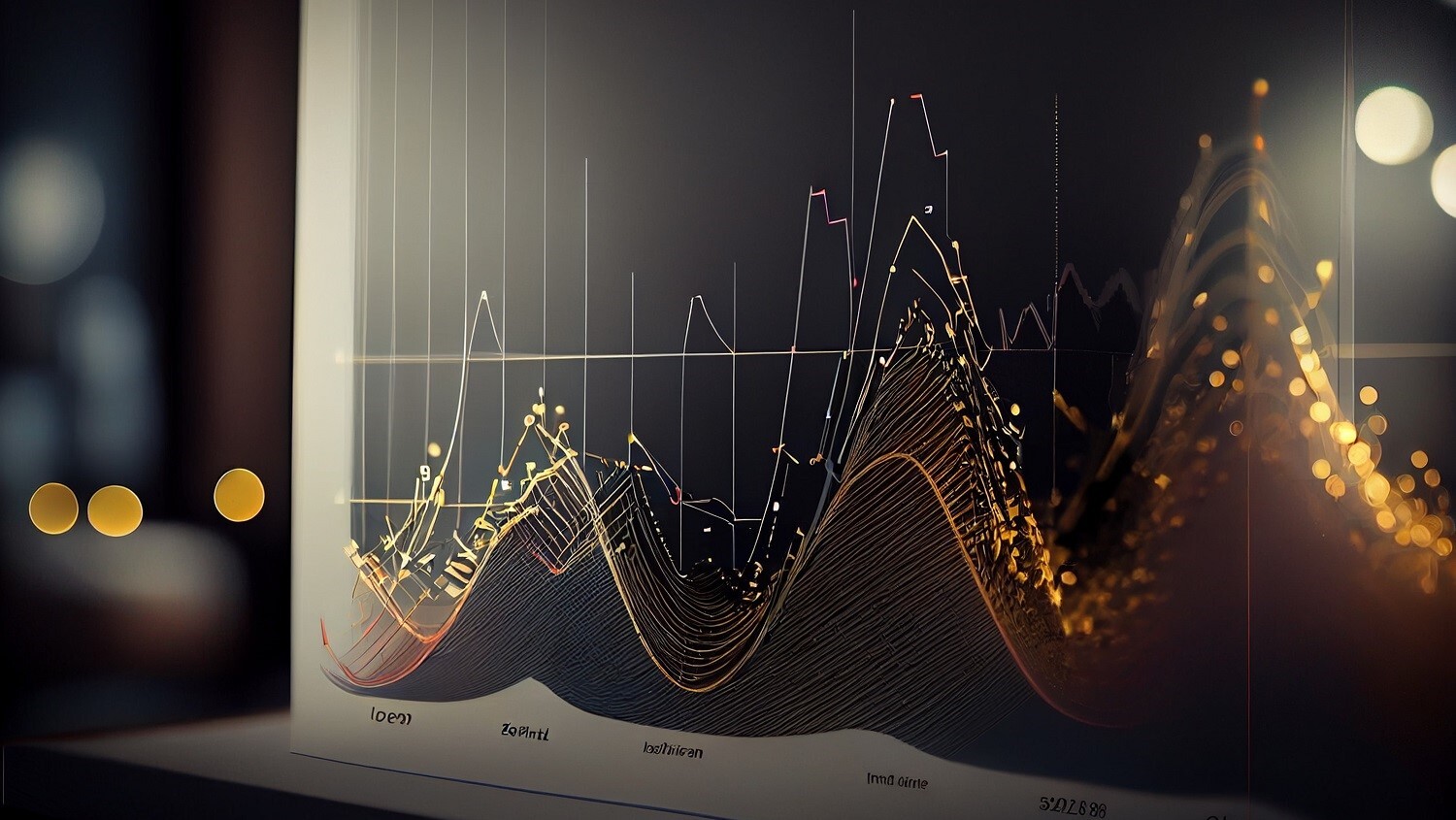

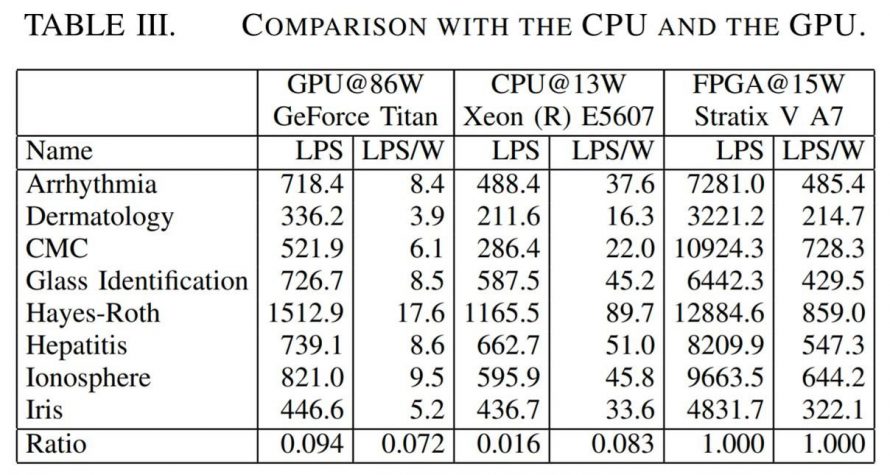

GPU、CPU、FPGAの計算効率に関する実験結果を図3に示します。LPSは、Lookups Per Secondの略であり、決定木の計算速度(論文には明記されていませんが1秒あたりに計算した決定木の数と推測されます)を意味します。LPS/Wは、電力1WあたりのLPSを意味します。Name列は、データセットの名称を意味します。詳しい実験環境を知りたい方は[1]をご参照下さい。

決定木の計算速度に関して、FPGAはGPUの10.7倍、CPUの14倍となっています。電力効率については、FPGAはGPUの61.3倍、CPUの12.1倍となっています。FPGAは、CPUやGPUに比べ、処理の高速化と省エネ化を図れるハードウェアであることがわかります。

図3.実験結果

(参考文献[1]より引用)

4.まとめ

FPGAは、書き換え可能なハードウェアデバイスであるため、計算対象に応じた最適な回路を構成することができます。FPGAを用いることにより、高速化や省電力化を図れます。昨今、エッジAIへの注目が高まっていることから、今後FPGAは更に重要な技術になっていくと考えられます。

皆さんも興味があれば、FPGAのプログラミングに取り組んでみてください!!

きっとPythonなどの高級言語だけでは実現できなかった新たなアプローチ、新たな発見があると思います。

また、エッジAIについてご興味のある方は、エッジAI講座のご受講をぜひご検討ください。

スキルアップAIでは、毎週水曜日に実践的AI勉強会「スキルアップAIキャンプ」を開催しています。勉強会では、様々な実践的テーマを取り上げ、データ分析・AI開発の実務力アップにつながるヒントをご提供します。講師が参加者の皆さんからの質問や悩みに答えるコーナーもあります。

興味がある方はぜひ参加してみてください!

5.補足

GPUを用いてランダムフォレストの高速化を図る方法をNVIDIA社が公開しています。

ご興味のある方はこちらをご覧ください。

その他、FPGAに関して有用な情報として、参考文献[2][3]があります。[2]では、メモリ間のデータ転送の効率化について述べられています。[3]は、FPGAを理解するうえで必要な知識がよくまとまっています。

6.参考文献

[2] Berkin Akin, Zeshan A. Chishti, and Alaa R. Alameldeen. 2019. ZCOMP: Reducing DNN Cross-Layer Memory Footprint Using Vector Extensions. In Proceedings of the 52nd Annual IEEE/ACM International Symposium on Microarchitecture (MICRO ’52). Association for Computing Machinery, New York, NY, USA, 126–138. DOI:https://doi.org/10.1145/3352460.3358305

[3]編集 天野英晴 “FPGAの原理と構成”, オーム社, 2016年

【監修】スキルアップAI 取締役CTO 小縣信也

AI指導実績は国内トップクラス。「太陽光発電発電量予測および異常検知」など、多数のAI開発案件を手掛けている。日本ディープラーニング協会主催2018E資格試験 優秀賞受賞、2019#1E資格試験優秀賞受賞。著書「徹底攻略ディープラーニングE資格エンジニア問題集」(インプレス)。

配信を希望される方はこちら

また、SNSでも様々なコンテンツをお届けしています。興味を持った方は是非チェックしてください♪

公開日: